Как проводились оценка и отбор российских научных журналов в базу данных Russian Science Citation Index (RSCI) на Web of Science

Публикуем статью, подготовленную по материалам Рабочей группы по оценке и отбору журналов в Russian Science Citation Index (RSCI) на Web of Science. Ее зампредседателя является первый проректор, директор ИСИЭЗ НИУ ВШЭ Леонид Гохберг, также возглавляющий тематический экспертный совет по социальным и гуманитарным наукам.

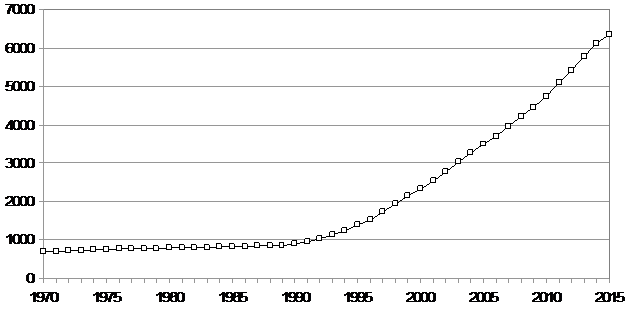

Количество научных журналов, издаваемых в мире, непрерывно растет. Россия в этом плане тоже не является исключением. На рисунке 1 приведен график изменения количества издаваемых в России научных журналов. Рост количества журналов ускорился в 90-е годы прошлого столетия и составляет сейчас около 300 новых журналов ежегодно. То есть фактически в России в среднем каждый день появляется новое научное периодическое издание.

Этот рост объясняется в том числе и объективными причинами, характерными для развития мировой науки — появлением новых направлений исследований, дроблением направлений с выделением более специализированных журналов, формированием новых научных школ, ростом количества ученых и т.д. Есть, однако, и косвенные причины, провоцирующие рост количества научных журналов и количества научных публикаций в мире. Это повсеместное использование библиометрических показателей для оценки научной деятельности, стимулирующее ученых чаще публиковаться, причем иногда, к сожалению, в ущерб качеству самих работ.

Рисунок 1. Динамика изменения количества журналов, выходящих в Российской Федерации (по данным РИНЦ на июль 2016 г.)

В настоящее время в России всего издается более 6000 журналов, которые условно можно отнести к категории научных. Условно, поскольку сюда включены не только чисто научные издания, но и научно-практические, научно-производственные, научно-образовательные, общественно-политические, научно-популярные издания. Одна из основных отличительных черт научного журнала — рецензирование поступающих рукописей. Большинство из журналов, индексируемых в РИНЦ, заявляют о наличии такого рецензирования. Однако проверить это весьма непросто. Кроме того, рецензирование тоже бывает разное. Часто полноценное рецензирование с привлечением нескольких внешних экспертов подменяется внутренним рецензированием, когда статьи для публикации отбирает редакционная коллегия или только главный редактор. Существуют также журналы, которые, декларируя наличие рецензирования, на самом деле его вообще не осуществляют.

Необходимо отметить, что РИНЦ не проводит какого-либо входного отбора научных журналов по их качеству. Задача РИНЦ — максимально полный охват всего публикационного потока российских ученых, чем национальный индекс принципиально отличается от международных баз данных Web of Science и Scopus, куда отбираются только лучшие журналы. Это необходимо учитывать и при выборе наукометрических показателей, рассчитываемых в РИНЦ, для оценки научной деятельности. Так, например, количество публикаций ученого в РИНЦ говорит лишь о его публикационной активности, но ничего не говорит о качестве этих работ. В то же время вполне возможно выделить в РИНЦ ядро лучших журналов, качество которых не вызывает сомнений, и рассчитывать для них свои показатели. Такой проект по оценке научного уровня журналов и формированию их высокорейтингового сегмента был реализован в 2015 году и завершился созданием пула изданий, вошедших в базу данных Web of Science

Инициаторами проекта по размещению лучших российских журналов на этой платформе стали компании Thomson Reuters и Научная электронная библиотека eLIBRARY.RU. Первая является правообладателем самой авторитетной международной базы данных научного цитирования Web of Science, вторая — разработчиком и оператором Российского индекса научного цитирования (РИНЦ). Компании совместно выступили с идеей создания новой базы данных Russian Science Citation Index (RSCI), включающей 1000 лучших российских научных журналов.

Для Thomson Reuters этот проект интересен в контексте дальнейшего развития линейки региональных индексов научного цитирования, размещенных на платформе Web of Science. RSCI стала четвертой региональной базой данных на этой платформе после китайской (Chinese Science Citation Database), латиноамериканской (SciELO Citation Index) и корейской (KCI Korean Journal Database).

Для Научной электронной библиотеки этот проект важен, поскольку позволяет выделить в РИНЦ ядро лучших российских журналов и усовершенствовать методику расчета библиометрических показателей, используемых для оценки ученых и научных организаций.

Успешная реализация проекта является также важным шагом на пути решения в перспективе целого ряда задач, в том числе, повышение качества российских научных журналов за счет приведения их к международным стандартам, рост библиометрических показателей российских журналов в Web of Science и интегральных показателей России в целом, интеграция российских научных журналов в мировое информационное пространство, продвижение результатов отечественных научных исследований на международном уровне.

Как объективно оценить качество научных журналов

Основной вопрос, который возник на стадии запуска проекта — каким образом отобрать лучшие журналы для включения в RSCI. Вариант использования широко применяемого в мире способа оценки журналов только по их импакт-фактору отпал сразу. Во-первых, этот показатель сильно зависит от научного направления. Во-вторых, этот показатель легко поддается искусственной «накрутке» за счет повышения самоцитирования в журнале или взаимного цитирования из «дружественных» журналов.

Вариант использования в качестве основы для формирования RSCI перечня ВАК также не рассматривался: в этот список журналы включаются на основе чисто формальных критериев, в результате чего туда попадают даже журналы, относящиеся к категории «мусорных» (т.е. журналы, быстро публикующие за деньги все поступающие статьи без какой-либо их экспертной оценки).

Проекты, в рамках которых проводились глобальная оценка качества национальных журналов и разделение их на категории в соответствии с их научным уровнем, известны в мировой практике. Однако в России систематической экспертной оценки всего корпуса издаваемых научных журналов никогда не проводилось, известны только работы по оценке журналов в рамках отдельных научных направлений. В этом смысле проект по формированию RSCI оказался уникальным — не только тем, что стал первым в своем роде, но и многообразием методов, которые использовались для достижения максимально объективной оценки качества изданий

Существует два основных подхода к оценке результатов научной деятельности — использование библиометрических показателей и экспертиза. Эти же подходы используются и при оценке научных журналов. Каждый из этих подходов имеет свои плюсы и минусы, поэтому в идеальном случае желательно сочетать оба подхода.

Использование библиометрических показателей привлекательно потому, что позволяет быстро провести оценивание или ранжирование большого количества объектов — публикаций, ученых, организаций, журналов и т.д. К достоинствам этого подхода также обычно относят его объективность. В то же время этот подход часто оказывается слишком упрощенным для оценки такого сложного направления человеческой деятельности как научное исследование.

Экспертная оценка позволяет провести при необходимости всесторонний анализ и оценку научного исследования, но при этом занимает много времени. Основным недостатком этого подхода считается субъективность, которая может оказывать серьезное влияние на результаты оценки. Субъективность подхода может проявляться на разных стадиях процесса оценивания — начиная с выбора соответствующих экспертов и заканчивая интерпретацией результатов экспертизы.

Несмотря на принципиально разные способы оценки, между экспертизой и библиометрией много общего. По своей сути, оценка с помощью библиометрических показателей тоже является одной из форм экспертизы. Взять, к примеру, такой показатель, как число публикаций в ведущих международных журналах. Наличие статей в таких журналах означает, что эти работы прошли рецензирование, то есть экспертную оценку на стадии приема рукописи к публикации. Или другой показатель — число цитирований. Наличие ссылок на статью означает, что другие ученые таким способом косвенно уже оценили эту работу путем ее цитирования, то есть это тоже является формой экспертизы, но уже с помощью всего научного сообщества.

Соответственно, и проблемы при использовании этих двух способов оценки во многом общие. Поэтому их не нужно противопоставлять друг другу, а, наоборот, использовать совместно. Добиться адекватных результатов можно, только грамотно сочетая преимущества разных подходов к оценке результатов научной деятельности.

Для организации работы по оценке и отбору журналов в RSCI была сформирована Рабочая группа, члены которой возглавили соответствующие тематические экспертные советы. В ее состав вошли:

- Григорьев А.И. (председатель Рабочей группы) — вице-президент РАН, председатель научно-издательского совета РАН, научный руководитель ГНЦ Институт медико-биологических проблем РАН (биологические науки и мультидисциплинарные журналы);

- Баранов А.А. — директор Научного центра здоровья детей РАМН (медицинские науки);

- Гохберг Л.М. (зам. председателя Рабочей группы — первый проректор НИУ ВШЭ, директор Института статистических исследований и экономики знаний НИУ ВШЭ (социальные и гуманитарные науки);

- Еременко Г.О. — генеральный директор Научной электронной библиотеки eLIBRARY.RU (консультативный совет по библиометрии);

- Каблов Е.Н. — Президент Ассоциации государственных научных центров, Генеральный директор ФГУП «Всероссийский институт авиационных материалов» ГНЦ (инженерные и технические науки);

- Козлов В.В. — вице-президент РАН, директор Математического института им. В.А.Стеклова РАН (математические, компьютерные и информационные науки);

- Лачуга Ю.Ф. — академик-секретарь отделения сельскохозяйственных наук РАН (сельскохозяйственные науки);

- Соболев Н.В. — главный научный сотрудник Института геологии и минералогии им. В.С. Соболева СО РАН (науки о Земле);

- Хохлов А.Р. — проректор МГУ им. М.В.Ломоносова (физические и химические науки);

- Назаренко А.Я. — НИСО РАН, ученый секретарь Рабочей группы.

Руководителями тематических направлений были сформированы экспертные советы, куда были привлечены ведущие ученые, представители различных научных организаций (профильных отделений и научных центров РАН, федеральных и исследовательских университетов, государственных научных центров и др.). Каждый из членов Рабочей группы координировал организацию экспертизы журналов по одному из основных научных направлений. Кроме того, был создан постоянно действующий консультативный совет при РИНЦ, куда вошли специалисты по наукометрии. В компетенцию этого совета входила подготовка рекомендаций по методическим вопросам библиометрической оценки научных журналов.

Окончательное решение о включении журнала в состав RSCI принимала Рабочая группа в соответствии с заключениями тематических экспертных советов, полученными на основании анализа и обобщения следующей информации:

- результаты оценки журналов экспертами по основным тематическим направлениям;

- формальные критерии отбора журналов;

- библиометрические показатели журнала в РИНЦ;

- общественная экспертиза журналов ведущими российскими учеными.

Ниже более подробно освещены основные особенности экспертной оценки уровня научных журналов тематическими советами, общественной экспертизы журналов ведущими российскими учеными, расчета и учета библиометрических показателей и формальных критериев.

Формальные критерии

Основной целью использования некоторых формальных критериев для отбора журналов на начальной стадии было исключение из рассмотрения экспертами журналов, не соответствующих основным принципам формирования базы данных RSCI. В частности, на первом этапе из всех журналов, обрабатываемых в РИНЦ, были отобраны только журналы, издаваемые в Российской Федерации (на данный момент достигнута договоренность о возможности включения в RSCI на следующем этапе достойных журналов, издаваемых на русском языке в других странах). Не рассматривались реферативные, научно-популярные журналы, издания, не выходящие в настоящее время, а также совсем новые издания, по которым просто еще недостаточно информации для их оценки.

Не рассматривались также переводные версии российских журналов — для оценки качества таких журналов использовалась оригинальная русскоязычная версия. В то же время при расчете библиометрических показателей для таких журналов учитывалось цитирование обеих версий журнала. Однако была исключена возможность двойного учета ссылок из оригинальной статьи и ее переводной версии.

Библиометрическая оценка

Основной задачей этого этапа оценки российских научных журналов было обеспечить экспертов набором основных наукометрических показателей для каждого из рассматриваемых журналов. При этом была осуществлена минимизация влияния известных недостатков импакт-фактора на результаты оценки с тем, чтобы позволить, во-первых, провести, по-возможности, корректное кроссдисциплинарное сравнение уровня журналов, и, во-вторых, подавить попытки некоторых журналов продвинуться вперед за счет различных манипуляций, не связанных напрямую с ростом качества научных публикаций.

В качестве базового показателя для ранжирования журналов был выбран пятилетний импакт-фактор. Основная проблема импакт-фактора, которая упоминается чаще всего — это его сильная зависимость от области научных исследований. Действительно, практика цитирования в разных направлениях науки отличается, как с количественной, так и с качественной точки зрения. В частности, один из важнейших показателей, который влияет на импакт-фактор и сильно варьируется от области к области — это среднее число ссылок в публикации. В самом деле, чем больше среднее число ссылок у статьи, тем больше вероятность у статей по этому научному направлению быть процитированными. Поэтому, чтобы сравнивать между собой журналы в разных областях науки, этот фактор необходимо скорректировать. Самый простой способ — нормировка числа полученных цитирований на среднее число ссылок в статье.

Другой фактор, который может вносить существенные искажения при междисциплинарном сравнении журналов — это различия в структуре списков цитируемой литературы. Например, в естественных науках в основном цитируются статьи в журналах, а в общественных и гуманитарных науках гораздо больше доля нежурнальных публикаций (монографий, сборников статей и т.д.). Поэтому правильнее нормировать рассчитываемые показатели цитирования не на среднее число всех ссылок в статье, а на среднее число ссылок на журнальные публикации. Еще корректнее учитывать при этом ссылки не на все статьи в журналах, а только на журналы, индексируемые в базе данных (то есть журналы, ссылки из которых учитываются при расчете показателей).

Хронологическое распределение цитирований журнала также сильно зависит от тематического направления. В интенсивно развивающихся областях науки статья начинает цитироваться практически сразу после ее опубликования, но через несколько лет устаревает и уже практически не цитируется. В некоторых науках, особенно общественных, наоборот — максимум в распределении цитирований наблюдается через 5-10 лет, причем публикации долго сохраняют свою актуальность и могут цитироваться десятилетиями.

Влияние этого фактора проявляется, когда период расчета ограничивается определенным временным промежутком. Например, при определении классического импакт-фактора учитываются ссылки только на статьи, опубликованные в журнале в течение последних двух лет. Соответственно, у журнала из быстроразвивающейся области науки за два года будут учтена значительно большая часть ссылок, чем у журнала, основная часть ссылок на статьи которого будет сделана позже. При этом нельзя утверждать, что первый журнал лучше, чем второй, поскольку по прошествии времени количество ссылок на них может сравняться, просто эти ссылки не учитываются при расчете импакт-фактора.

Чтобы сгладить этот эффект, рекомендуется при расчетах увеличивать величину цитатного окна, то есть периода, в течение которого считаются ссылки. Тот же импакт-фактор, но рассчитанный на пятилетнем периоде, уже менее чувствителен к различиям в хронологическом распределении между научными направлениями. Более того, увеличение цитатного окна имеет еще один положительный эффект — растет статистическая достоверность и стабильность полученных результатов, поскольку они рассчитываются на большем объеме данных.

Одно из неизбежных последствий повсеместного применения библиометрии — это повышенное внимание ученых и научных руководителей всех уровней к достижению высоких показателей. Иногда этому начинают уделять больше внимания, чем собственно качеству самих исследований. В условиях, когда от определенных статистических показателей начинает напрямую зависеть получение грантов или карьерный рост ученого, финансовое положение научного журнала или выделение бюджетных средств научной организации, довольно трудно удержаться от соблазна каким-то образом оптимизировать процесс так, чтобы получать более высокие статистические оценки.

Способов таких существует немало. Наиболее простой и распространенный способ— самоцитирование или цитирование коллегами друг друга. Этот способ часто применяют и редакторы научных журналов, вынуждая авторов цитировать свои работы или работы других ученых, опубликованные в этом же журнале. В некоторых журналах регулярно публикуются обзоры, содержащие большое количество ссылок на предыдущие статьи в этом же журнале. Тем самым искусственно завышается импакт-фактор журнала.

Необходимо отметить, что само по себе самоцитирование — это вполне естественное для научных публикаций явление. Обычно автор опирается в своей новой работе на предыдущие свои исследования, и логика изложения материала требует ссылки на предыдущие публикации. Тем более в научном журнале, особенно в крупном, где публикуется множество авторов, работающих в этом же направлении, ссылки на другие статьи, опубликованные в этом же журнале — вполне нормальное явление. Однако, когда у научного журнала уровень самоцитирования сильно зашкаливает по сравнению с аналогичными изданиями, это серьезный повод для анализа на предмет применения искусственных способов накрутки импакт-фактора. Такие примеры есть как в международных журналах, так и в российских.

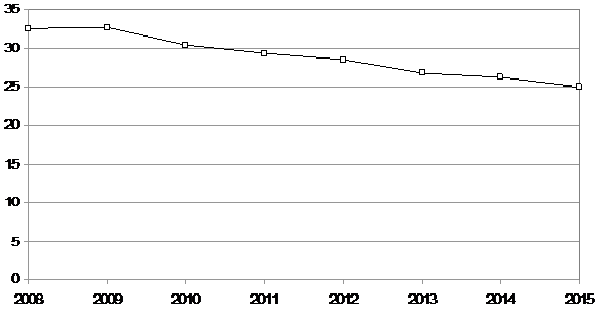

Какой же уровень самоцитирования журнала можно считать приемлемым? Около 80% журналов, входящих в базу данных Web of Science Core Collection, имеют коэффициент самоцитирования (т.е. отношение цитирования статей журнала в нем самом к общему цитированию статей этого журнала) не более 20%. Для российских журналов, индексируемых в РИНЦ, коэффициент самоцитирования не более 20% имеют только 45% журналов. В то же время необходимо отметить положительную тенденцию, наметившуюся в последние годы — средний уровень самоцитирования в российских журналах постепенно падает, за 5 лет падение составило 5% (Рис. 2).

Существуют и более изощренные способы накрутки импакт-фактора, когда, например, редакции дружественных журналов (например, относящихся к одному издательству) договариваются об обмене ссылками. Есть также примеры, когда ученые объединяются через социальные сети и намеренно цитируют друг друга. Не исключено, что в ближайшее время появятся целые сети по торговле ссылками по аналогии с теми, что существуют для продажи кликов на интернет сайты.

Конечно, все это уже не имеет никакого отношения к качеству статей, опубликованных в журнале. Поэтому методика расчета библиометрических показателей, используемая при ранжировании журналов, должна учитывать возможность такого рода искусственного влияния и, по возможности, его минимизировать. В рамках данного проекта для этого была проведена дополнительная нормировка импакт-факторов журналов по индексу Херфиндаля. Такая нормировка приводит к заметной деградации показателей для журналов с высоким уровнем самоцитирования, а также журналов, получающих внешние цитирования из очень ограниченного круга других журналов.

На основании рассчитанного по данной методике библиометрического показателя был составлен общий рейтинг журналов по всем научным направлениям. Значения показателей журналов и их места в этом рейтинге, вместе с другими библиометрическими показателями журналов, были предоставлены экспертам.

Рисунок 2. Динамика изменения среднего двухлетнего коэффициента самоцитирования (%) российских журналов.

Экспертная оценка

К оценке журналов с участием экспертов предъявлялось важное требование — минимизация влияния субъективных факторов. Так, исказить картину могли недостаток широты научного кругозора эксперта, выставление им более высоких оценок журналам, где он, эксперт, публиковался, или является рецензентом/членом редколлегии, а также конфликт эксперта с редакцией. Один из эффективных способов добиться объективности — увеличение количества экспертов, участвующих в процедуре оценки. Однако это усложняет процедуру оценки и увеличивает сроки экспертизы. Значительно увеличить количество участвующих в оценке экспертов удалось с помощью общественного голосования через Интернет.

Для организации работы по оценке и отбору журналов в RSCI была сформирована Рабочая группа, члены которой возглавили соответствующие экспертные советы по тематическим направлениям, (такие как, биологические науки или общественные науки) в которых работают журналы. В их задачу входила прежде всего оценка научного уровня журналов. Учитывая специфику научных направлений, методика отбора журналов в каждом экспертном совете могла несколько отличаться, однако основные критерии для отбора журналов были общими:

- научный уровень статей, опубликованных в журнале за последние 5 лет;

- степень неравномерности статей по качеству;

- актуальность статей, опубликованных в журнале;

- известность (узнаваемость) и авторитетность журнала среди профессионального сообщества;

- позиции журнала в России и в мире в данной предметной области.

Перед экспертами не ставилась задача отобрать в RSCI ровно 1000 журналов (количество, предусмотренное в договоре между Thomson Reuters и НЭБ) или какое-то другое фиксированное число журналов. Точно также не было задано каких-то начальных квот по количеству журналов по направлениям или пропорций между ними. В задачу экспертных советов входило отобрать журналы, не только занимающие лидирующие позиции в стране в данном научном направлении, но и представляющие интерес для международного научного сообщества.

При создании RSCI впервые в отечественной практике была проведена масштабная оценка уровня журналов с привлечением большого числа действующих ученых (общественная экспертиза). Расширенная общественная экспертиза журналов проводилась путем онлайнового анкетирования более 30 тысяч ведущих российских ученых. Экспертная оценка проводилась на сайте eLIBRARY.RU в течение 40 дней путем заполнения специальных экспертных анкет.

Для организации широкой общественной экспертизы российских научных журналов была использована база данных российских ученых, сформированная в информационно-аналитической системе Science Index, запущенной НЭБ в 2011 году. Каждый участник опроса мог самостоятельно выбрать не более трех научных направлений и оценить журналы по каждому из этих направлений, плюс, по желанию - мультидисциплинарные журналы. Каждый журнал в анкете мог быть отнесен к одному из четырех уровней:

4* — журнал международного уровня (достоин включения в Web of Science Core Collection);

3* —журнал национального уровня (безусловно достоин включения в RSCI);

2* — журнал среднего уровня (потенциальный кандидат для включения в RSCI);

1* — журнал низкого уровня (не достоин включения в RSCI).

В результате общественной экспертизы было получено 12800 экспертных анкет. Общее количество оценок, проставленных журналам, составило 240 тыс. (вариант «журнал не знаком эксперту» здесь не учитывается). Для каждого журнала были рассчитаны два дополнительных показателя: общее число полученных оценок и средняя оценка. Первый характеризует известность журнала (но, естественно, зависит и от числа ученых, работающих в данном направлении), второй отражает научный уровень и авторитетность журнала в профессиональном научном сообществе. Вместе с библиометрическими данными показатели были переданы в экспертные советы по научным направлениям.

Анализ результатов общественной экспертизы показал высокий уровень требований ученых к журналам. Так, к журналам мирового уровня было отнесено всего 110 журналов из почти 3000 включенных в анкеты (средняя оценка > 3.5 из 4). Оценку > 3 получили 530 журналов, > 2.75 — 900 журналов, >2.5 — 1400 журналов.

Окончательное решение о включении журнала в состав RSCI принимала Рабочая группа в соответствии с заключениями тематических экспертных советов, полученными на основании анализа и обобщения результатов оценки журналов экспертами, формальных критериев, библиометрических показателей журнала и общественной экспертизы журналов ведущими российскими учеными. Рабочая группа отобрала 652 журнала, достойных для их включения в Russian Science Citation Index. Это значительно меньше, чем предполагавшаяся изначально тысяча, что, с одной стороны, свидетельствует о достаточно строгих критериях отбора, а с другой, дает возможность постепенно расширять список на следующих этапах отбора.

Данный список не является окончательным и неприкосновенным. Принято решение о продолжении работы по ежегодному мониторингу качества журналов и внесению дополнений и изменений в список журналов, размещенных в Russian Science Citation Index на платформе Web of Science. В состав Рабочей группы включен академик-секретарь отделения историко-филологических наук РАН В.А.Тишков, который возглавил экспертный совет по гуманитарным наукам, выделенный в самостоятельное тематическое направление.

Любой российский журнал, выбрав правильную редакционную политику и установив строгие критерии рецензирования и принятия рукописей к публикации, имеет реальный шанс быть включенным в RSCI на следующих этапах отбора. И наоборот, если у журнала будет наблюдаться явная деградация качества публикуемых статей или будут обнаружены нарушения редакционно-издательской этики (в том числе попытки искусственной "накрутки" библиометрических показателей), то такие журналы будут повторно рассматриваться в экспертных советах и могут быть исключены из RSCI.

После формирования списка журналов для RSCI появилась возможность посмотреть, как распределены отобранные журналы по научным направлениям и насколько это распределение отличается от тематического распределения российских журналов в Web of Science и в РИНЦ.

Получилось, что если в Web of Science в основном индексируются российские журналы в области естественных и технических наук, то в РИНЦ, наоборот, в большей степени представлены общественно-гуманитарные и мультидисциплинарные журналы. Что касается RSCI, то для нее по большинству направлений получаются промежуточные значения, то есть в RSCI распределение журналов по направлениям более равномерное, чем в Web of Science. Это можно считать положительным моментом, поскольку недостаточный охват российских общественно-гуманитарных журналов в Web of Science затрудняет использование этой базы для корректного отображения деятельности российских ученых и научных организаций общественно-гуманитарного профиля.

В то же время, если сравнивать RSCI с РИНЦ, то доля отобранных журналов в области общественно-гуманитарных наук существенно меньше, чем в области наук естественных, технических, медицинских и сельскохозяйственных. Это означает, что научный уровень большинства общественно-гуманитарных журналов, по мнению экспертов, пока не соответствует мировому уровню, либо эти журналы представляют недостаточный интерес для международного научного сообщества.

В заключение стоить обратить внимание на некоторые проблемы, связанные с использованием списков научных журналов для оценки научной деятельности. Несмотря на широкое распространение такого подхода, он часто является предметом острой критики со стороны научного и издательского сообщества. Причем критике подвергается не только и не столько включение журналов в список, сколько сам принцип использования подобных списков для оценки научной деятельности.

Действительно, как обычно на практике используют результаты отбора научных журналов? Составляют список условно «хороших» журналов (WOS, Scopus, перечень ВАК). И, к примеру, только статьи, опубликованные в журналах из этого списка, учитываются при оценке результативности научной деятельности ученых и организаций. Так или иначе, при таком подходе оценка группы журналов спускается на уровень оценки отдельных статей, в них опубликованных. Именно это и является основной ошибкой. Действительно, такой подход исходит из предположения, что научные статьи близки по своему уровню не только в пределах одного журнала, но и в пределах журналов, отнесенных к одной группе. Анализ распределения статей в журнале по их цитированию это предположение опровергает, и показывает, что разброс в цитировании конкретных статей может быть очень высок. Поэтому нельзя утверждать, что статьи двух разных ученых, будучи опубликованы в одном журнале, имеют примерно одинаковый уровень.

Кроме того, существует проблема некорректного использования таких списков научными администраторами, которые начинают стимулировать исследователей публиковаться только в журналах из «хорошего» списка. То есть сами списки журналов из инструмента статистической оценки научной деятельности превращаются в инструмент административного влияния и давления на ученых. Это приводит, в свою очередь, к оттоку хороших публикаций из журналов, не попавших в список, их постепенной деградации и потере конкурентоспособности.

Все это не означает, что ранжирование научных журналов не имеет практического применения. Важно, чтобы в процессе оценки научной деятельности, основанной на ранжировании журналов, принимались во внимание описанные выше методологические ограничения такого подхода.

Авторы: Г.О. Еременко (член Рабочей группы, ген.директор Научной электронной библиотеки elibrary.ru), А.Я. Назаренко (ученый секретарь Рабочей группы, советник вице-президента РАН)

Смотрите также:

Лучшие российские журналы будут размещены в Web of Science

Инструменты развития научных журналов

Журнал «Форсайт» и еще 13 научных журналов Вышки вошли в Russian Science Citation Index

На платформе Web of Science появилась база данных лучших российских журналов

Гохберг Леонид Маркович

Лаборатория экономики инноваций: Руководитель